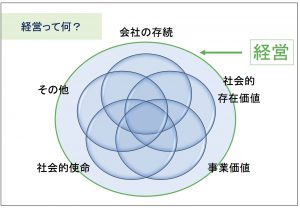

経営とは何を意味するのだろう?

現代の世界には経営という言葉があらゆる場所で使われています。

経営学、経営コンサルタント、経営者などなど。

そもそも、経営とは何を意味した言葉なのでしょうか。

一般的には

・会社を倒産させない。

・企業の社会的存在価値を高めること。

・企業の成長や発展による事業価値を高めること。

以上のことが考えられます。

企業が持つ使命を遂行する事により、利益を生み出すことが経営という事です。

歯科医業は『最高の医療の提供や平等な医療の提供』が使命の一つと考えられています。

より多くの人に医療を提供する為にも健全な経営が必要となるのでしょう。